آموزش جامع فایل Robots.txt و meta robots

یادگیری نحوه ساخت robots.txt و meta robots برای موفقیت در سئو تکنیکال اولویت دارد. در این راهنمای کوتاه میآموزید چگونه این فایل ربات را ایجاد کنید و چگونه از متاربت های استفاده کنید.

تفاوت فایل robots.txt و تگهای meta robots

قبل از اینکه به اصول تگهای meta robots و فایل robots.txt بپردازیم، مهم است که تفاوتهای این دو را بدانید، اما به خاطر داشته باشید هیچیک از آنها بر دیگری برتری ندارند. فایل robots.txt کرالرها را برای مشاهده ساختار کلی سایت راهنمایی میکنند. اما تگهای متا برای تنها یک صفحه خاص بهکار میروند. هرچند از فایل ربات هم میتوان برای بهعنوانمثال: بستن دسترسی یک صفحه استفاده کرد. اما اینکه از کدامیک آنها استفاده کنید یک تصمیم شخصی است.

robots.txt چیست؟

محتوای فایل robots.txt به خزندههای گوگل و سایر موتورهای جستوجو میگوید که باید کدام صفحات را کرال کنند و کدام صفحات را کرال نکنند.Googlebot نمونهای از یک خزنده است. گوگل از Googlebot را برای خزیدن در وبسایت و ثبت اطلاعات آنها برای درک چگونگی رتبهبندی سایت در نتایج جستجوی گوگل استفاده میکند.

چرا robots.txt مهم است؟

برای درک اهمیت این فایل بهتر است با یک مثال آغاز کنیم. اگر یک سایت بزرگ داشته باشید که تعداد زیادی صفحات با کیفیت پایین داشته باشد، اگر از این فایل استفاده نکنید رباتهای گوگل با هر بار کرال کردن سایت شما تمام این صفحات کیفیت را مشاهده میکنند و میزان کرال باجت یا همان بودجه خرش رباتهای گوگل در سایت به صفحات با کیفیت پایین اختصاص خواهد یافت. اما اگر صفحات بیکیفیت را در این فایل disallow کنید، کرال باجت صرف صفحات با کیفیت بالا که قصد رتبه گرفتن در آنها را دارید اختصاص خواهد یافت.

چگونه از robots.txt استفاده کنیم؟

همانطور که گفتیم استفاده از robots.txt برای موفقیت در سئو واجب است. موتورهای جستجو براساس آنچه در فایل robots.txt با استفاده از دستورها و عبارات که به آنها میگویید، در سایت شما میخزند و آن را ایندکس میکنند.

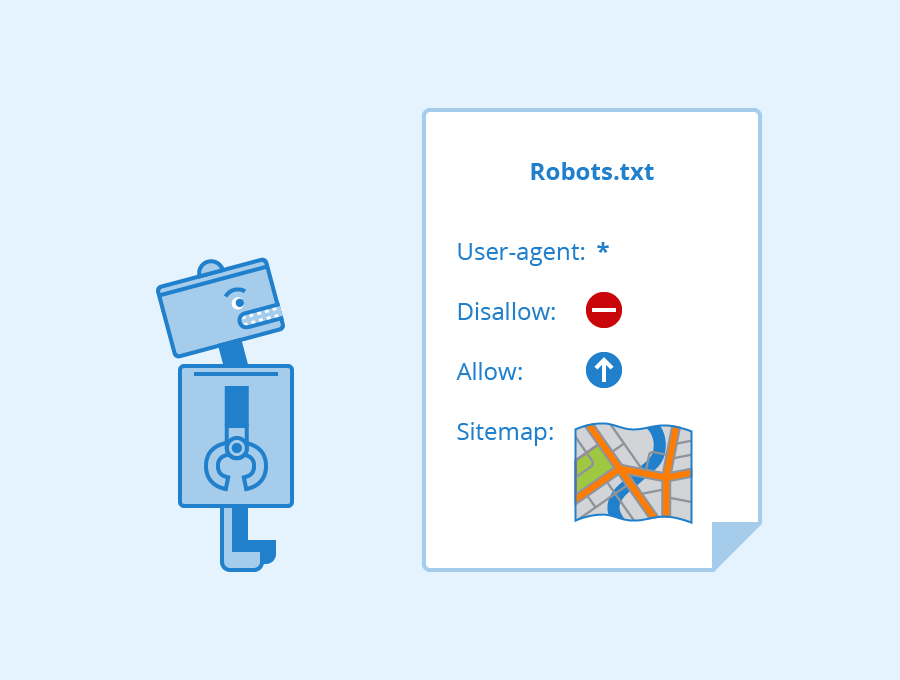

در زیر دستورالعملهای مشترک robots.txt وجود دارد که باید بدانید:

User-agent: *

این دستور در خط آغازین فایل قرار میگیرد و به این معنا است که دستورهایی که در خطهای بعدی نوشته میشود مربوط به تمام اسپایدر ها است. درصورتیکه قصد دارید فایل ربات را تنها برای موتور جستوجوی گوگل ایجاد کنید باید از دستور User-agent: Googlebot استفاده کنید.

Disallow: /

این دستور، دسترسی تمام کرالرها را به سایت مسدود میکند.

Disallow:

این دستور به رباتها میگوید که تمام سایت را بررسی کنند.

Allow: *

این دستور به معنای دسترسی رباتها به محتوای سایت است.

بهعنوانمثال استفاده از دستور زیر به رباتها میگوید که تمام فایلهای با فرمت pdf در سایت را برای جلوگیری از به وجود

Disallow: /ebooks/*.pdf

دسترسی کدام صفحات را با استفاده از robots.txt مسدود کنیم؟

فایلهای robots.txt اغلب برای حذف دایرکتوریهای خاص، دستهها یا صفحات از SERP مورداستفاده قرار میگیرند. همانطور که گفتیم شما با استفاده از دستور disallow میتوانید به رباتها بگویید که صفحات یا داکتوری خاصی را کرال نکنند. برخی از این صفحات به شرح زیر هستند.

- صفحاتی دارای محتوای تکراری یا اصطلاحاً duplicate page

- صفحات صفحهبندی یا paginations

- صفحات حساب کاربری

- سبد خرید

- بخش چتها

- صفحاتی مانند: تشکر و...

- صفحات مدیریت سایت

مهم است بدانید که همه خزندهها از فایل robots.txt شما پیروی نمیکنند. پس اگر داده حساسی در صفحات دارید آنها را با استفاده از فایل htaccess مسدود یا 403 کنید.

اشتباهات رایج در نوشتن robots.txt

نوشتن نام فایل با حروف بزرگ

تنها نامی که میتوانید برای این فایل قرار دهید robots.txt است نه robots.txt یا robots.txt

در سئو و بهینه سازی سایت همیشه از حروف کوچک استفاده کنید.

قرار ندادن فایل robots.txt در دایرکتوری اصلی.

اگر میخواهید فایل robots.txt پیدا شود، باید آن را در دایرکتوری اصلی سایت خود قرار دهید. دایرکتوری اصلی سایت همان public html است.

غلط

www.mysite.com/tshirts/robots.txtصحیح

www.mysite.com/robots.txtساختار غلط User-Agent

غلط

Disallow: Googlebotصحیح

User-agent: Googlebot

Disallow: /قرار دادن چند محدودیت در یک خط Disallow

غلط

Disallow: /css/ /cgi-bin/ /images/صحیح

Disallow: /css/

Disallow: /cgi-bin/

Disallow: /images/محدود کردن تمام فایلهای یک دایرکتوری خاص

غلط

User-agent: *

Disallow: /pajamas/flannel.html

Disallow: /pajamas/corduroy.html

Disallow: /pajamas/cashmere.htmlصحیح

User-agent: *

Disallow: /pajamas/

Disallow: /shirts/تگهای meta robots چه چیزی هستند؟

تگهای ربات، تگهای HTML هستند که به موتور جستجو در مورد نحوه خزیدن و ایندکس کردن صفحات در وبسایت شما میپردازند.

تگهای متا ربات به بخش < head <در صفحه وب اضافه میشوند. بهعنوانمثال

<meta name=”robots” content=”noindex” />انواع تگ متا ربات

تگهای متا روبات دارای دو نوع تگ هستند:

- تگ متا ربات

- X-robots-tag

تگ متا ربات meta robots

تگهای متا ربات اغلب توسط کارشناسان سئو استفاده میشود.

این به شما این امکان را میدهد که به رباتها در مورد کرال کردن صفحات خاصی بگویید. بهعنوانمثال

<meta name=”googlebot” content=”noindex,nofollow”>این دستور به رباتهای موتورهای جستوجو میگوید که صفحه مذکور را ایندکس نکنند و لینکهای داخل صفحه را دنبال نکنند. پس این صفحه در نتایج جستوجو نمایش داده نمیشود.

اگر از تگهای ربات متعددی استفاده میکنید لازم است که هر یک را در خط جداگانهای قرار دهید.

X-robots-tag

X-robots-tag به شما امکان انجام همان کارهایی که با استفاده از metarobots انجام میدهید را میدهند اما درون header یک HTTP response.

اساساً، این کار به شما کارایی بیشتری نسبت به تگهای متا ربات میدهد.

بااینحال, شما به دسترسی به فایلهای php، htaccess ویا سرور نیاز دارید.

برای مثال، اگر میخواهید یک تصویر یا ویدئو را مسدود کنید، اما نه کل صفحه، میتوانید به جای آن از X-robots-tag استفاده کنید.

تگهای robots.txt و meta robots با همکار میکنند.

یکی از بزرگترین اشتباهاتی که هنگام کار بر روی وبسایتهای مشتری میبینم، زمانی است که فایل robots.txt با آنچه در متا رباتها بیان کردهاید، تطبیق نمیکند.

برای مثال، فایل robots.txt، صفحه را از ایندکس شدن پنهان میکند، اما تگهای متا ربات بر خلاف آن عمل میکنند.

موضوع: بهینه سازی سایت سئو تکنیکال

در بحث پیرامون این مقاله شرکت کنید

ارسال دیدگاه

انواع لینکها

انواع لینکها

سئو کلاه سیاه یا بلک هت چیست

سئو کلاه سیاه یا بلک هت چیست

سئو سایت شرکتی

سئو سایت شرکتی

الگوریتم پاندا چیست؟

الگوریتم پاندا چیست؟

حمیدرضا

12 شهریور 1401 ساعت 17:34

سلام بسیار مفید بود ممنونم

تیم پشتیبانی

13 شهریور 1401 ساعت 02:34

سلام

خوشحالیم که مفید واقع شد.

موفق باشید.